RAG im Unternehmen: Wenn KI nachschlägt statt zu raten

Erklärung von Retrieval-Augmented Generation (RAG) und wie es Unternehmen dabei hilft, ein 'ChatGPT für betriebliches Wissen' aufzubauen.

Was ist Retrieval-Augmented Generation (RAG)?

Stellen Sie sich vor, Sie schreiben eine wichtige E-Mail und können dabei nicht nur auf Ihr Gedächtnis zurückgreifen, sondern haben all Ihre Notizen, Dokumente und Referenzen griffbereit. Genau das ist RAG für künstliche Intelligenz.

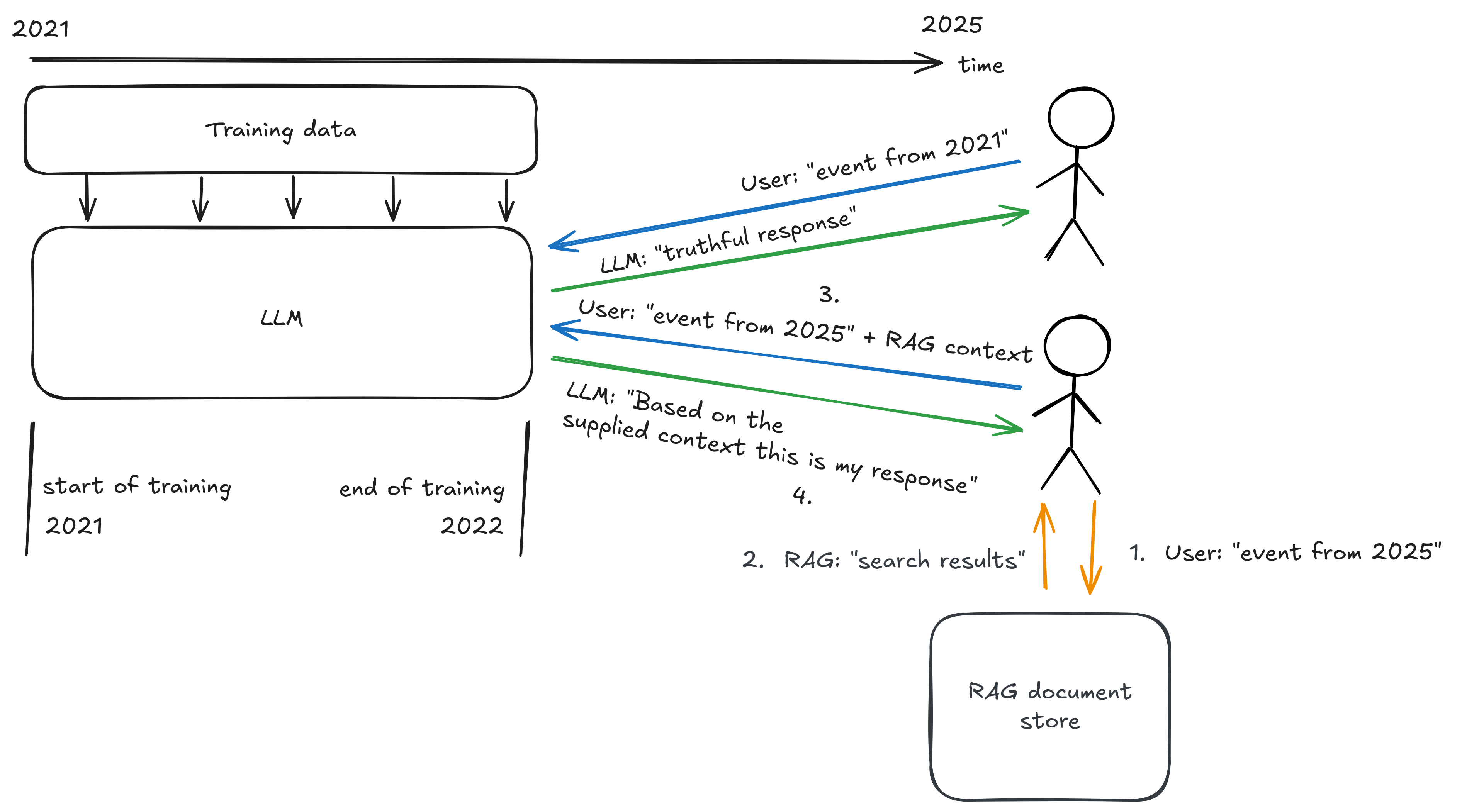

RAG kombiniert zwei Fähigkeiten: das Abrufen relevanter Informationen aus einer Wissensbasis und das intelligente Generieren von Antworten. Die KI durchsucht erst externe Dokumente, bevor sie antwortet – sie schlägt nach, statt zu improvisieren.

RAG und LLMs

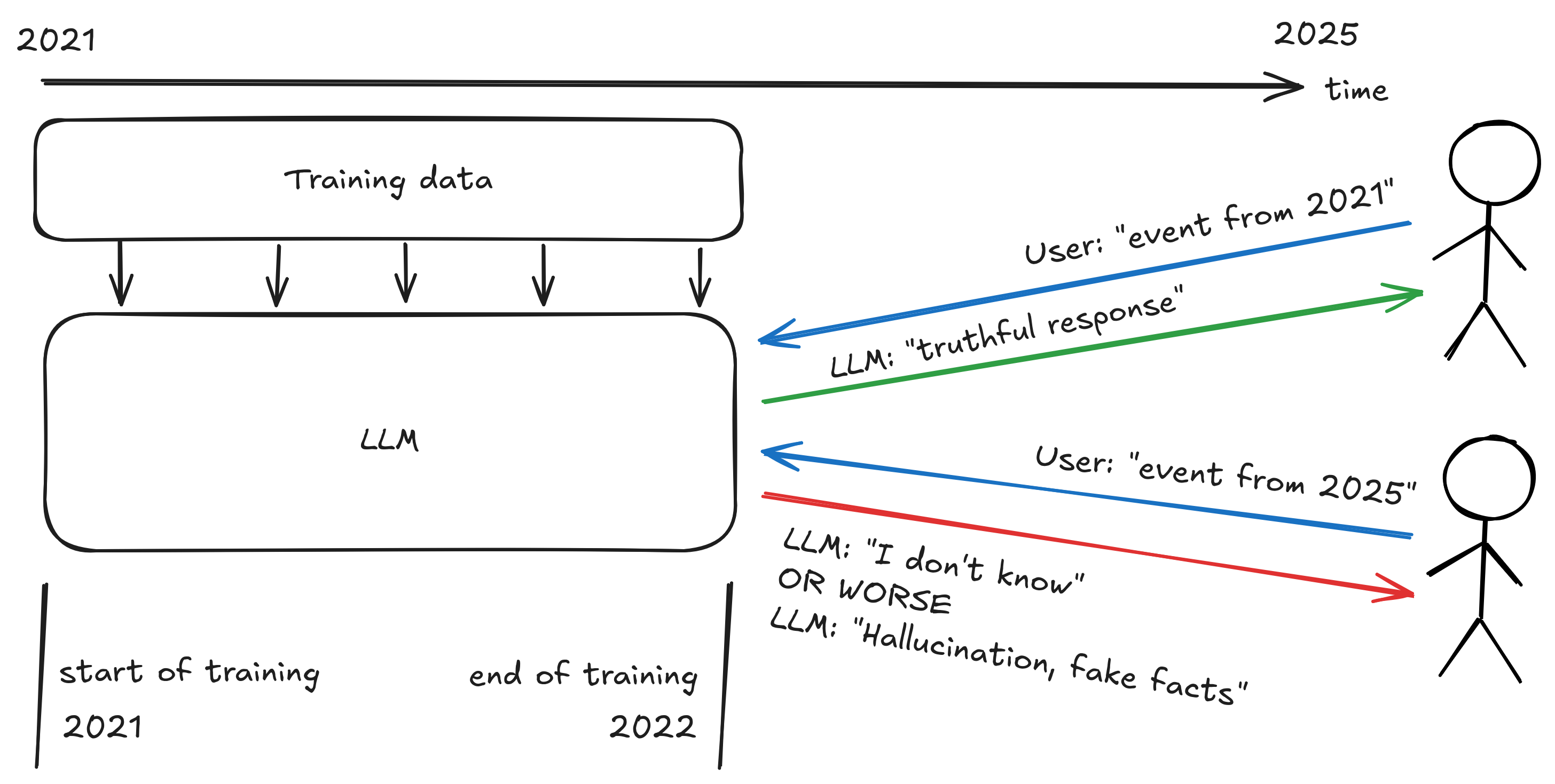

Large Language Models (LLMs) wie GPT oder Mistral sind beeindruckende Sprachakrobaten. Sie verstehen Kontext, formulieren eloquent und können komplexe Zusammenhänge erklären. Doch Sprachmodelle werden nur bis zu einem bestimmten Zeitpunkt trainiert. Danach können sie kein Wissen über neuere Ereignisse abrufen. Ein LLM aus dem Jahr 2020 weiß beispielsweise nichts von der Wiederwahl Donald Trumps, da sein Kenntnisstand nicht darüber hinausreicht.

RAG gewährt diesen Modellen Zugang zu aktuellen und spezifischen Informationen. Dazu gehören auch Informationen, die dem LLM während des Trainings nicht zur Verfügung standen, wie beispielsweise betriebliche Dokumente.

KI weiß nicht alles

Sprachmodelle können weit weniger als gedacht. Während ihres Trainings haben sie zwar Millionen von Texten gesehen, aber:

- Sie kennen keine firmeninternen Dokumente.

- Sie wissen nichts über aktuelle Ereignisse.

- Sie haben keinen Zugriff auf spezialisierte Datenbanken.

- Sie können keine vertraulichen oder proprietären Informationen enthalten.

LLMs werden auf einer sehr umfangreichen, aber auch sehr breit gefächerten Wissensbasis trainiert. Sie sind daher oft nicht zuverlässig, wenn es um spezifische Themen geht.

KI ist kreativ

Ein weites Problem ist, dass sich KI an Dinge “erinnern” kann, die nie passiert sind. Diese sogenannten Halluzinationen entstehen, wenn Modelle plausibel klingende, aber falsche Informationen generieren. Hinter einem Sprachmodell steht mathematisch gesehen ein Algorithmus, der mithilfe von Wahrscheinlichkeiten das passendste nächste Wort erstellt. Dabei basiert jede Entscheidung auf Mustern aus riesigen Textmengen, die das Modell während des Trainings gelernt hat, um menschliche Sprache vorherzusagen.

Es ist daher nicht ratsam KI-Modellen blind zu vertrauen. RAG wirkt dem entgegen, indem es die KI zwingt, sich auf konkrete Quellen zu stützen.

KI ist vergesslich

Schlussendlich ist die Aufnahmefähigkeit einer KI begrenzt. Bei zu langen Benutzereingaben kann das Modell nicht alle bereitgestellten Inhalte berücksichtigen. So ist es beispielsweise nicht möglich, einem Modell 100 Dokumente zu übergeben und es dann zu bitten, spezifische Informationen aus den Dokumenten zu suchen. Es braucht daher eine Möglichkeit, relevante Informationen zu finden und die passendste Auswahl dem Modell zu übergeben.

Der Einsatz von RAG im Unternehmen

Sicherheitsbedenken

Für Unternehmen ist die zentrale Frage: Wie nutzen wir KI, ohne sensible Daten zu gefährden?

In ihrem 2025 erschienenen Buch über OpenAI zeigt Karen Hao, wie schnell aus ursprünglich idealistischen Non-Profit-Projekten gewinnorientierte KI-Imperien entstehen können. Diese Entwicklung macht deutlich, dass Unternehmensdaten nicht in externe Trainingsdatensätze gehören.

RAG bietet eine Antwort. Die Dokumente bleiben im Unternehmen. Das LLM selbst lernt nichts dazu – es liest nur, was man ihm zum jeweiligen Zeitpunkt gibt. Nach der Antwort ist das Dokument wieder vergessen.

Auf diese Weise können auch streng vertrauliche Informationen genutzt werden, ohne dass sie in ein externes KI-Modell übertragen werden.

Performance

RAG-Systeme müssen schnell sein. Niemand wartet gerne, während die KI erst hunderte Dokumente durchsucht.

Die Kunst liegt in effizienten Suchalgorithmen – oft basierend auf Vektorähnlichkeiten – die in Sekundenbruchteilen die relevantesten Informationen finden.

Vorteile von RAG im Unternehmensalltag

Wissen effizient nutzen

2024 beschreibt Yuval Noah Harari, wie Informationsnetzwerke die Menschheit geformt haben – und wie KI diese Netzwerke fundamental verändert. RAG macht Unternehmen zu intelligenten Informationsnetzwerken:

- Onboarding beschleunigen: Neue Mitarbeiter finden Antworten, ohne Kollegen zu unterbrechen

- Silos aufbrechen: Wissen aus verschiedenen Abteilungen wird zugänglich

- Best Practices verbreiten: Bewährte Lösungen werden wiederentdeckt statt neu erfunden

- Compliance sicherstellen: Aktuelle Richtlinien sind immer abrufbar

Das Wissen, das jahrelang in E-Mails, Wikis und Laufwerken vergraben war, wird wiederbelebt.

Was die Zukunft bringt

RAG als zentraler Baustein der Unternehmens-KI

RAG ist kein experimentelles Feature mehr, sondern bildet die Grundlage intelligenter Unternehmenssysteme. Jede KI-Assistenz, die mit echten Unternehmensdaten arbeitet, benötigt einen Retrieval-Mechanismus.

Die Entwicklung geht in Richtung:

- Multimodales Retrieval: Nicht nur Text, sondern auch Bilder, Grafiken, Videos werden verarbeitet

- Bewertung von Quellen: Die KI lernt, welche Quellen vertrauenswürdig sind

- Kontext-Bewusstsein: Besseres Verständnis dafür, was in welcher Situation relevant ist

Agentic AI

Die nächste Evolutionsstufe sind autonome KI-Agenten, die nicht nur Informationen abrufen, sondern auch aktiv handeln können.

Ein RAG-basierter Agent könnte beispielsweise:

- selbstständig nach fehlenden Informationen suchen,

- mehrere Quellen vergleichen und Widersprüche identifizieren.

- proaktiv Updates liefern, wenn sich relevante Dokumente ändern.

- Workflows basierend auf gefundenen Informationen anstoßen.

RAG würde dann nicht mehr nur reaktiv (“Beantworte diese Frage.”) arbeiten, sondern auch proaktiv (“Überwache diese Themen und informiere mich bei Veränderungen.”).

Damit reiht sich Agentic AI in die Themengebiete der digitalen Transformation und der Automatisierung von Geschäftsprozessen ein.

Fazit

RAG bringt zwei Welten zusammen: die Ausdruckskraft moderner Sprachmodelle und die Verlässlichkeit von echten Informationen. Für Unternehmen bedeutet das, KI gezielt einzusetzen, ohne vertrauliches Wissen offenzulegen oder die Kontrolle zu verlieren. Am Ende zählt nicht, wie viel eine KI weiß (oder nicht weiß) – sondern, wie gut sie relevante Antworten findet.

Quellen

- Zweig, Katharina: Weiß die KI, dass sie nichts weiß? Was Sprachmodelle können – und was nicht (2025)

- Harari, Yuval Noah: NEXUS: Eine kurze Geschichte der Informationsnetzwerke von der Steinzeit bis zur künstlichen Intelligenz (2024)

- Hao, Karen: Empire of AI: Dreams and Nightmares in Sam Altman’s OpenAI (2025)

- Suleyman, Mustafa: The Coming Wave (2023)